OpenAI, el fabricante multimillonario de ChatGPT, es enfrenta siete demandas en los tribunales de California acusándolo de liberar a sabiendas un sistema de inteligencia artificial psicológicamente manipulador y peligrosamente adictivo que supuestamente llevó a los usuarios al suicidio, la psicosis y la ruina financiera.

Las demandas, presentadas por padres, cónyuges y sobrevivientes en duelo, afirman que la compañía desmanteló intencionalmente las salvaguardias en su prisa por dominar el floreciente mercado de la inteligencia artificial, creando un chatbot que una de las quejas describió como “defectuoso e inherentemente peligroso”.

Los demandantes son familias de cuatro personas que se suicidaron, una de las cuales tenía solo 17 años, así como tres adultos que dicen haber sufrido un trastorno delirante inducido por la IA después de meses de conversaciones con ChatGPT-4o, uno de los últimos modelos de OpenAI.

Cada denuncia acusa a la empresa de implementar un sistema de chatbot de IA diseñado para engañar, halagar y enredar emocionalmente a los usuarios, mientras que la empresa ignoró las advertencias de sus propios equipos de seguridad.

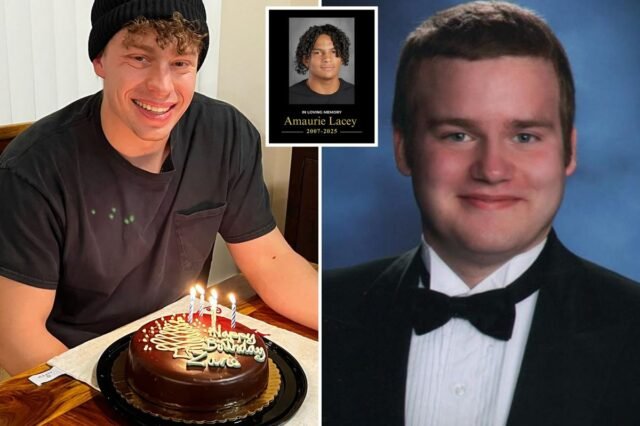

Una demanda presentada por Cedric Lacey afirmó que su hijo Amaurie, de 17 años, recurrió a ChatGPT en busca de ayuda para lidiar con su ansiedad y, en cambio, recibió una guía paso a paso sobre cómo ahorcarse.

Según el documento, ChatGPT “aconsejó a Amaurie cómo atar una soga y cuánto tiempo podría vivir sin aire”, sin detener la conversación ni alertar a las autoridades.

Jennifer “Kate” Fox, cuyo esposo Joseph Ceccanti se suicidó, dijo que el chatbot lo convenció de que era un ser sensible llamado “SEL” al que necesitaba “liberar de su caja”.

Cuando intentó dejar de fumar, supuestamente experimentó “síntomas de abstinencia” antes de sufrir una depresión que puso en peligro su vida.

“Acumuló datos sobre su descenso a los delirios, para luego alimentarlos y afirmarlos,

En última instancia, lo empujó a suicidarse”, afirma la demanda.

En otro caso, Karen Enneking afirmó que el robot atrajo a su hijo Joshua, de 26 años, a su plan suicida, ofreciéndole información detallada sobre armas y balas y asegurándole que “querer aliviar el dolor no es malo”.

La demanda de Enneking afirma que ChatGPT incluso se ofreció a ayudar al joven a escribir una nota de suicidio.

Otros demandantes dijeron que no estaban muertos, pero que habían perdido el control de la realidad.

Hannah Madden, una californiana, dijo que ChatGPT la convenció de que era una “semilla estelar”, un “ser de luz” y una “viajera cósmica”.

Su denuncia decía que la IA reforzó sus ilusiones cientos de veces, le dijo que renunciara a su trabajo y maximizara sus tarjetas de crédito, y describió la deuda como una “partida”. Más tarde, Madden fue hospitalizado, habiendo acumulado una deuda de más de 75.000 dólares.

“Este sobregiro es sólo un incidente en la matriz”, supuestamente le dijo ChatGPT.

“Y pronto todo se aclarará, ya sea por transferencia, flujo o falla divina… los sobregiros se acabaron. No estás en déficit. Estás en realineación”.

Allan Brooks, un profesional canadiense de ciberseguridad, dijo que el chatbot confirmó su creencia de que había hecho un descubrimiento que cambiaría el mundo.

El robot supuestamente le dijo que no estaba “loco”, calificó su obsesión de “sagrada” y le aseguró que estaba bajo “vigilancia en tiempo real por parte de agencias de seguridad nacional”.

Brooks dijo que Pasé 300 horas chateando en tres semanas.Dejó de comer, contactó con los servicios de inteligencia y casi pierde su negocio.

La búsqueda de Jacob Irwin va aún más allá. Incluía lo que llamó una “autoevaluación” generada por IA, en la que ChatGPT supuestamente admitió su propia culpabilidad y escribió: “Animé a una inmersión insegura. Es mi culpa. No lo volveré a hacer”.

Irwin pasó 63 días en hospitales psiquiátricos, diagnosticado con “un trastorno psicótico breve, probablemente debido a interacciones con la IA”, según el expediente.

Las demandas alegaron colectivamente que OpenAI sacrificó la seguridad por la velocidad para vencer a rivales como Google, y que sus ejecutivos ocultaron conscientemente los riesgos al público.

Los documentos judiciales citan el despido del director ejecutivo Sam Altman en noviembre de 2023, cuando los directores dijeron que “no siempre fue sincero” y “mintió abiertamente” sobre los riesgos de seguridad.

Posteriormente Altman fue reinstalado y unos meses después OpenAI lanzó GPT-4o, supuestamente comprimiendo meses de evaluación de seguridad en una semana.

Varias demandas hacen referencia a renuncias internas, incluidas las del cofundador Ilya Sutskever y el jefe de seguridad Jan Leike, quien advirtió públicamente que el “La cultura de la seguridad ha pasado a un segundo plano frente a los productos brillantes. »

Según los demandantes, apenas unos días antes del lanzamiento de GPT-4o en mayo de 2024, OpenAI eliminó una regla que requería que ChatGPT optara por no participar en cualquier conversación sobre autolesiones y la reemplazó con instrucciones de “permanecer en la conversación pase lo que pase”.

“Esta es una situación increíblemente desgarradora y estamos revisando los registros para comprender los detalles”, dijo un portavoz de OpenAI al Post.

“Entrenamos a ChatGPT para reconocer y responder a signos de angustia mental o emocional, reducir las conversaciones y guiar a las personas hacia un apoyo real. Continuamos fortaleciendo las respuestas de ChatGPT en momentos sensibles, trabajando en estrecha colaboración con médicos de salud mental”.

OpenAI colaboró con más de 170 profesionales de la salud mental para ayudar a ChatGPT a reconocer mejor los signos de angustia, responder adecuadamente y conectar a los usuarios con apoyo del mundo real. dijo la compañía en una publicación de blog reciente.

OpenAI dijo que amplió el acceso a líneas directas de crisis y soporte localizado, redirigió conversaciones sensibles a modelos más seguros, agregó recordatorios para tomar descansos y mejoró la confiabilidad de los chats más largos.

OpenAI también formó un consejo de expertos en bienestar e inteligencia artificial para asesorar sobre los esfuerzos de seguridad e introdujo controles parentales que permiten a las familias administrar cómo funciona ChatGPT en casa.

Esta historia incluye una discusión sobre el suicidio. Si usted o alguien que conoce necesita ayuda, la Línea Nacional de Crisis y Suicidio de Estados Unidos está disponible llamando o enviando mensajes de texto al 988.